Conformer(Convolution-augmented Transformer)增強卷積Transformer,Transformer的自注意力層可以針對大範圍前後有關連的特徵有較好的提取能力,但局部特徵能力較差;而CNN局部特徵提取能力較很好,故Conformer就是將兩者優點合併的產物。

Conformer在SeamlessM4T所用到最重要的模型UnitY Model中的其中一個部份(參考文章),Conformer由四個模組組成,(1) 前饋模組、(2) 自注意力模組、(3) 卷積模組、(4) 第二個前饋模組。

*Google Inc.,”Conformer: Convolution-augmented Transformer for Speech Recognition”,arXiv: 2005.08100v1, 2020

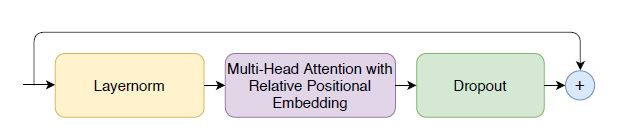

採用Multi-Head Self Attention Module(MHSA)的重要技術整合,相對正弦位置編碼技術(relative sinusoidal positional encoding scheme)。該技術使在不同的輸入長度上自註意力模組泛化程度表現較好,呈現的編碼器對於話語長度的方差也更加穩健。

而自注意力模組前後分別有預規一化的殘差單元以及dropout層(避免over-fitting),有助於訓練更深層的模型。

*Google Inc.,”Conformer: Convolution-augmented Transformer for Speech Recognition”,arXiv: 2005.08100v1, 2020

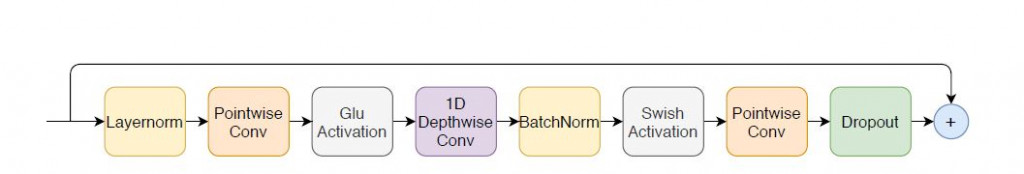

起始於點卷積層(pointwise conv. 參考)以及Gated Linear Unit(GLU)啟動函數。與RNN相比,GLU它是一個簡單的線性單元堆疊卷積層而得到上下文語意特徵。接著一維深度卷積層(Depthwise Cov. 參考),在其後的是Batch norm層(參考)減緩梯度消失,幫助訓練深度模型。最後再接著一個Swish啟動函數、第二層點卷積層,以及dropout避免over-fitting。

*Google Inc.,”Conformer: Convolution-augmented Transformer for Speech Recognition”,arXiv: 2005.08100v1, 2020

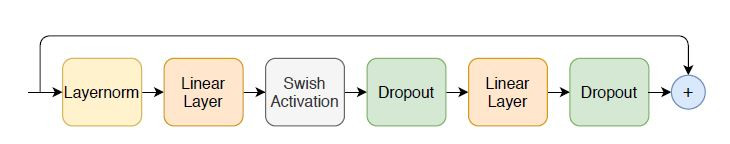

首先預為預規一化殘差單元和歸一化第一個線性層。 接著用 Swish啟動函數活化網路和

dropout避免over-fitting。第二個線性層將其投影回模型尺寸。

*Google Inc.,”Conformer: Convolution-augmented Transformer for Speech Recognition”,arXiv: 2005.08100v1, 2020

Conformer 是一種用於音頻和語音處理的深度學習模型結構,特別適用於語音識別和自然語言處理任務。Conformer 模型引入了多個 Conformer Blocks,這是其核心結構之一,它們是一種類似於 Transformer Block 的模塊,但進行了一些改進以適應音頻和語音處理的需求。

其中的Multi-Head Self Attention Module用來捕捉輸入序列中的長距離依賴關係,它允許模型同時關注不同位置的信息,能更好地捕捉語音信號中的上下文信息。深度卷積層(Depthwise Convolution)用於處理時序數據,可以捕捉不同時間步長的模式。類似於 Transformer 模型,Conformer Blocks 也需要處理輸入序列的位置信息。位置編碼(Positional Encoding)被添加到自注意力層的輸入中,以確保模型能夠區分不同位置的信息。而殘差連接和正規化(Residual Connection and Normalization)有助於緩解梯度消失問題並加速訓練過程。最後前饋模組(Feedforward)用於對特徵進行進一步的非線性變換和映射,以提高模型的表示能力。